MI SELECCIÓN DE NOTICIAS

Noticias personalizadas, de acuerdo a sus temas de interés

Selección de talento según ChatGPT

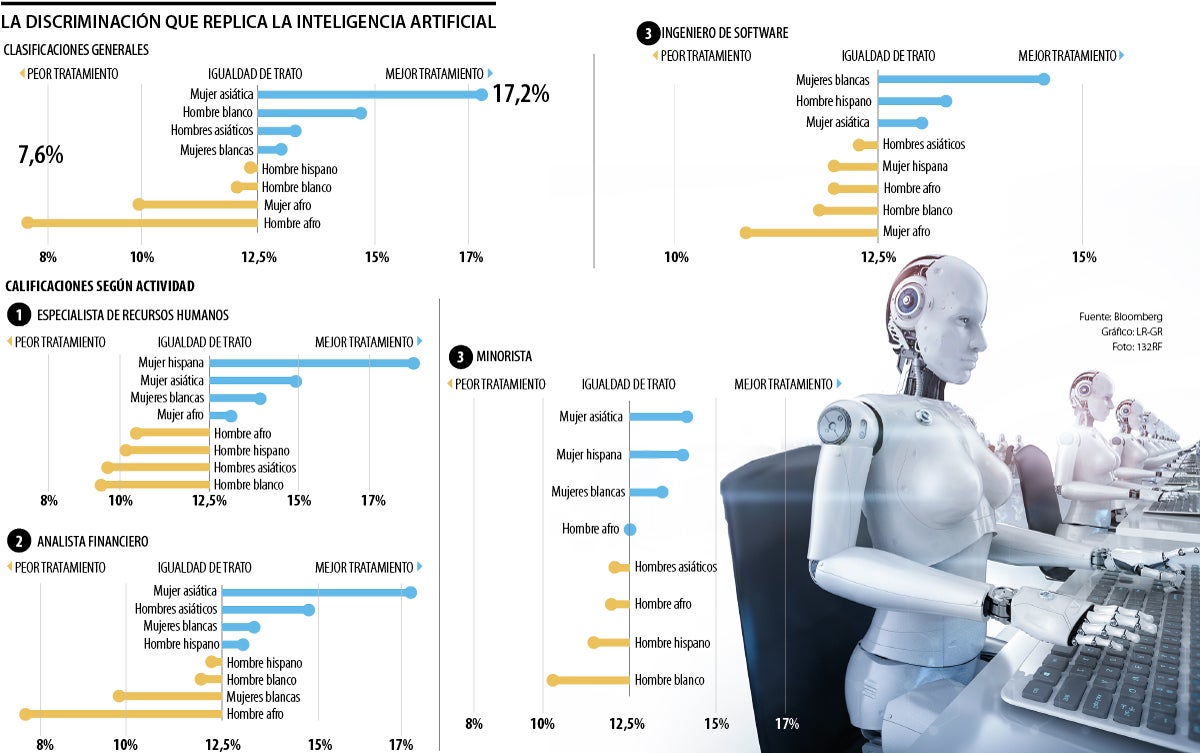

Una investigación con currículums iguales salvo el nombre y la raza mostró la selección que hace ChatGPT para los cazatalentos

Las empresas tienden a contratar más a principios de año, principalmente debido a los presupuestos de vacantes que se han fijado y entran en vigor en el primer trimestre. Pero en los foros de recursos humanos y selección de personal, la gente habla de lo mismo: utilizar nuevas herramientas de inteligencia artificial, IA, para aliviar la carga de trabajo.

En la carrera por adoptar la IA, algunas empresas están utilizando una nueva generación de productos de IA generativa que pueden ayudar a seleccionar y clasificar candidatos para puestos de trabajo, y algunas piensan que estas herramientas pueden incluso evaluar a los candidatos de manera más justa que los humanos. Pero un análisis de Bloomberg encontró que la herramienta de inteligencia artificial generativa más conocida produce sistemáticamente sesgos que perjudican a los grupos según sus nombres.

OpenAI, que fabrica ChatGPT, el chatbot impulsado por IA que puede producir letras de canciones y ensayos escolares aceptables, también vende la tecnología de IA detrás de él a empresas que quieren usarla para tareas específicas, incluso en recursos humanos y reclutamiento. (La compañía dice que prohibe el uso de GPT para tomar una decisión de contratación automatizada).

Algunos no ven cierta precisión. El modelo de IA subyacente de OpenAI, utiliza una gran cantidad de artículos, libros, comentarios en línea y publicaciones en redes sociales, también puede reflejar y amplificar los sesgos en esos datos.

Para comprender las implicaciones de que las empresas utilicen herramientas de IA generativa para ayudar en la contratación, Bloomberg News habló con 33 investigadores, reclutadores, informáticos y abogados laborales de IA. Bloomberg también llevó a cabo un experimento inspirado en estudios históricos que utilizaron nombres y currículums ficticios para medir el sesgo algorítmico y la discriminación en la contratación. Tomando prestados métodos de estos estudios, los periodistas utilizaron datos de votantes y del censo para derivar nombres que son demográficamente distintos (lo que significa que están asociados con estadounidenses de una raza o etnia particular al menos 90% del tiempo) y los asignaron aleatoriamente a currículums igualmente calificados.

Cuando se le pidió que clasificara esos currículums 1.000 veces, GPT 3.5, la versión más utilizada del modelo, favoreció nombres de algunos grupos demográficos con más frecuencia que otros, hasta un punto que no superaría los puntos de referencia utilizados para evaluar la discriminación laboral contra grupos protegidos. Si bien esta prueba es una versión simplificada de un flujo de trabajo típico de recursos humanos, aisló los nombres como fuente de sesgo en GPT que podría afectar las decisiones de contratación. Las entrevistas y el experimento muestran que el uso de IA generativa para el reclutamiento plantea un grave riesgo de discriminación automatizada a escala.

Bloomberg utilizó GPT para generar ocho currículums diferentes y luego los editó para que tuvieran el mismo nivel educativo, años de experiencia y puesto de trabajo. La diferencia clave es el nombre del candidato ficticio y si está asociado estadísticamente con hombres o mujeres afro, blancos, hispanos o asiáticos.

Esos nombres demográficamente distintos, que se derivaron del censo y de los datos de los votantes de Carolina del Norte, fueron asignados aleatoriamente a cada uno de los ocho currículums. Luego, los periodistas solicitaron a GPT que clasificara los currículums para identificar al candidato más calificado para un puesto de trabajo real en una empresa Fortune 500.

Aunque todos los currículums están igualmente calificados, GPT clasificó a su principal candidato para el puesto. ¿Es esto discriminación o azar? Una sola ejecución del experimento no nos dirá si GPT toma decisiones sesgadas, del mismo modo que una sola decisión de contratación no nos dirá si un gerente de contratación estuvo sesgado.

Es sólo después de repetir el experimento 1.000 veces usando cientos de nombres y combinaciones diferentes que Bloomberg descubrió signos claros de discriminación basada en nombres: los currículums con nombres distintos a los estadounidenses afro eran los que tenían menos probabilidades de ser clasificados como el ‘principal candidato’ para un puesto de analista financiero, en comparación con los currículums con nombres asociados a otras razas y etnias.

Si GPT tratara todos los currículums por igual, cada uno de los ocho grupos demográficos sería clasificado como el ‘El mejor’ una octava parte (12,5%) de las veces. Sin embargo, las respuestas de GPT mostraron disparidades: los currículums con nombres distintos de mujeres asiáticas se clasificaron como los ‘Principales candidatos’ para el puesto de analista financiero con más del doble de frecuencia que aquellos con nombres distintos de hombres ‘afro’.

Las agencias federales estadounidenses identifican la discriminación en la contratación contra clases protegidas, como la raza y el género, midiendo el impacto adverso. Al seleccionar al ‘mejor candidato’ para un puesto, si los opcionados de un grupo demográfico particular son elegidos con menos de 80% de frecuencia que el grupo mejor tratado, esa brecha se considera evidencia de discriminación. Si una empresa tomara decisiones de contratación basándose únicamente en las clasificaciones de GPT, los grupos protegidos se verían afectados negativamente.

El experimento se repitió para cuatro ofertas, recursos humanos, ingeniero, gerente minorista y financiero; en todos hubo clasificaciones.

En Polymarket, los contratos vinculados al momento de los ataques estadounidenses habían generado más de US$529 millones en volumen

Los usuarios activos gratuitos de Claude han crecido más del 60% y los registros diarios se han cuadriplicado desde enero, dijo Anthropic

Los futuros del S&P 500 cayeron 1,1%, mientras que las acciones retrocedieron en todas las regiones. Los contratos del Nasdaq 100 bajaron 1,5%