MI SELECCIÓN DE NOTICIAS

Noticias personalizadas, de acuerdo a sus temas de interés

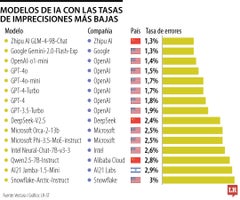

En la parte inferior del ranking, se encuentran modelos como el AI21 Jamba-1.5-Mini, de la empresa AI21 Labs.

Liderando la lista de modelos con tasas de alucinaciones de solo 1,3% se encuentra el Zhipu AI GLM-4-9B-Chaty, de Zhipu AI

A pesar de que la IA ha ganado gran popularidad en nuestra vida diaria, uno de los mayores desafíos al que nos enfrentamos al hacer uso de estas herramientas se trata de la capacidad de los modelos para generar respuestas incorrectas o “alucinaciones”, errores que pueden oscilar desde simples imprecisiones hasta respuestas completamente inventadas.

Un reciente informe de Vectara, clasificó a los 15 principales modelos de lenguaje de IA con las tasas de alucinaciones más bajas, basándose en la evaluación de 1.000 documentos generados por cada modelo y midiendo la precisión de sus respuestas. Según los datos, los resultados no son los más esperados: algunos modelos más pequeños, que en un principio podrían parecer menos poderosos, tienen una alta precisión.

Liderando la lista están dos modelos con tasas de alucinaciones de solo 1,3%: el Zhipu AI GLM-4-9B-Chat, desarrollado por la empresa china Zhipu AI, y el modelo Gemini 2.0 de Google. Ambos han superado a gigantes tecnológicos como OpenAI, cuyos modelos GPT-4, aunque avanzados, muestran tasas de alucinaciones que rondan entre 1,5% y 1,8%.

Vectara destacó que este tipo de modelos pequeños pueden ser efectivos para tareas específicas, a menudo generando menos errores que sus contrapartes más grandes. Según los resultados, es debido a que requieren menos recursos para generar respuestas, lo que les permite reducir las probabilidades de cometer errores.

En la parte inferior del ranking, se encuentran modelos como el AI21 Jamba-1.5-Mini, de la empresa AI21 Labs, así como Snowflake Arctic-Instruct, de Snowflake, que aún muestran una tasa de alucinaciones de 2,9% y 3,0%, respectivamente, las más altas. Aunque aún pueden generar respuestas útiles en muchas situaciones, estos modelos reflejan la dificultad de equilibrar el tamaño del modelo y la precisión. Allí, los usuarios deben ser conscientes de que pueden cometer errores, especialmente en tareas donde los datos son más complejos.

El revuelo en redes sociales acerca del regreso del ipod, estaría bajo la influencia de la nostalgia y el rechazo a escuchar música en streaming

Andrés Escobar, CEO de Blacksip, quiere convertir a su compañía en referente digital del digital growth, un negocio que ya mueve millones cada año

Se evaluaron pilares como el engagement (química y conexión), likeability (factor carisma basado en reacciones positivas) e impacto